Una tarde en Fort Benning, Georgia, dos aeromodelos despegaron, subieron a 800 y 1.000 pies, y empezaron a volar sobre la base militar en busca de una lona naranja, verde y azul.

Los aviones automatizados sin piloto volaron por su cuenta, sin orientación humana, sin ningún tipo de control.

Después de 20 minutos, uno de los aviones, transportando un equipo que procesa las imágenes de una cámara a bordo, se concentró en la lona y se contactó con el segundo avión, que volaba cerca y utilizó sus propios sensores para examinar el objeto de colores. Entonces uno de los aviones envía una señal a un vehículo no tripulado en tierra para dar un último vistazo, más de cerca.

Objetivo confirmado.

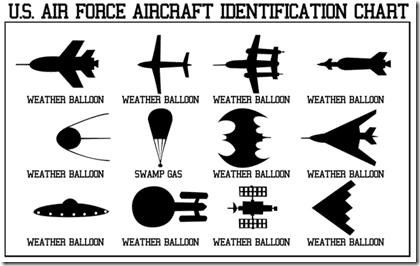

Este ejercicio exitoso en robótica autónoma podría presagiar el futuro de la manera como Estados Unidos va a la guerra: un día en que aviones cazan, identificar y atacan al enemigo basándose en cálculos realizados por software, y no en las decisiones tomadas por los seres humanos. Imagínese "Terminators" aéreos, pero con menos carne y sin viajes en el tiempo.

El objetivo en Fort Benning "es un objetivo bastante simple, pero se pensar en él como un sustituto", dijo Charles E. Pippin, un científico en el Georgia Tech Research Institute, que desarrolló el software para ejecutar la demostración. "Se pueden imaginar escenarios en tiempo real en los que se tienen 10 de estas cosas en el aire y algo que está sucediendo en el terreno y no tienes tiempo para que un ser humano piense 'necesito para hacer estas tareas'. Todo tiene que suceder mucho más rápido.

La demostración sentó las bases para avances científicos que permitan aviones no tripulados en la búsqueda de un objetivo humano y luego hacer una identificación basada en reconocimiento facial u otro software. Una vez que se da una coincidencia, un avión no tripulado podría lanzar un misil para eliminar el objetivo.

Los sistemas militares con un cierto grado de autonomía (como centinelas robóticos armados) han sido desplegados en la zona desmilitarizada entre Corea del Sur y del Norte y otras zonas de batalla potencial. Los investigadores no están seguros de qué tan pronto las máquinas serán capaces de colaborar y adaptarse de forma inteligente en condiciones de combate. Se podría tardar una o dos décadas o más. El ejército de EE.UU. está financiando numerosos proyectos de investigación en automatización para desarrollar máquinas que llevarán a cabo algunas tareas rutinarias ó peligrosas y mantener su ventaja sobre los potenciales adversarios, que también están trabajando en estos sistemas.

La eliminación de sospechosos de terrorismo y los insurgentes por drones armados, controlados por pilotos sentados en las bases a miles de kilómetros de distancia en el oeste de Estados Unidos, ha provocado las críticas de que la tecnología convierte la guerra en algo antiséptico. Las preguntas también se han planteado sobre la legalidad de los ataques con drones cuando se emplea en lugares como Pakistán, Yemen y Somalia, que no están en guerra con los Estados Unidos. Este debate se intensificará en los avances tecnológicos permiten que los expertos llaman la autonomía letal.

La perspectiva de máquinas capaces de percibir, razonar y actuar en entornos sin guión representa un desafío para la comprensión actual del derecho internacional humanitario. Los Convenios de Ginebra exigen a los beligerantes utilizar la discriminación y proporcionalidad, las normas podrían exigir que las máquinas puedan distinguir entre los combatientes enemigos, las tropas que se rinden y los civiles.

"El despliegue de estos sistemas refleja un cambio de paradigma y un cambio cualitativo importante en la conducción de las hostilidades", dijo Jakob Kellenberger, presidente del Comité Internacional de la Cruz Roja, en una conferencia en Italia este mes. "También se plantean una serie de cuestiones jurídicas, éticas y sociales, que deben ser considerados antes de que estos sistemas sean desarrollados o implementados".

Aviones no tripulados sobrevolando Afganistán, Pakistán y Yemen se puede mover de un punto a otro, y no está claro si la vigilancia y otras tareas que llevan a cabo en el modo autónomo. Incluso cuando están directamente vinculados a los operadores humanos, estas máquinas están produciendo tantos datos que los procesadores están tamizando el material que indique los objetivos, o al menos objetos de interés. Esta tendencia hacia una mayor autonomía sólo aumentará a medida que los militares de EE.UU. se desplazan de un único piloto volando un avión no tripulado, a un único piloto volando varios aviones a la vez.

Pero los humanos aún tienen la decisión de disparar, y en el caso de las huelgas de la CIA en Pakistán, esta decisión recae en el director de la agencia. En las operaciones futuras, si los drones son desplegados contra un enemigo sofisticado, puede haber mucho menos tiempo para la deliberación y una mayor necesidad de máquinas que pueden funcionar por sí solas.

El ejército de EE.UU. ha comenzado a lidiar con las implicaciones de las nuevas tecnologías.

"Autorizar una máquina a que tome decisiones de combate letal depende de que los líderes políticos y militares resuelvan cuestiones legales y éticas", según un tratado de la Fuerza Aérea denominado Plan de Vuelo de Aviones no tripulados de Sistemas 2009-2047. "Esto incluye la adecuación de las máquinas con esta capacidad, bajo qué circunstancias deben ser empleados, donde se encuentra responsabilidad por los errores y las limitaciones que se deben colocar en la autonomía de tales sistemas."

En el futuro, micro-drones podrán reconocer túneles y edificios, mulas robot para transportar equipo y sistemas móviles para recuperar a los heridos bajo el fuego. La tecnología ayudará a salvar vidas. Pero la trayectoria de la investigación militar ha llevado a exigir un régimen de control de armas para prevenir cualquier posibilidad de que los sistemas autónomos podrían dirigirse a los seres humanos.

En Berlín el año pasado, un grupo de ingenieros de robótica, filósofos y activistas de derechos humanos formaron el Comité Internacional de Robot de Control de Armas (ICRAC) y dijo que esas tecnologías podrían tentar a los políticos a pensar que la guerra puede ser menos sangrienta.

Algunos expertos también les preocupa que los estados hostiles u organizaciones terroristas podría hackear sistemas robóticos y redirigirlos. Mal funcionamiento también son un problema: En el sur de África en 2007, un cañón semiautónomo disparó a nueve soldados amigos.

El ICRAC gustaría ver un tratado internacional, como la prohibición de minas antipersonal, que deje por fuera de la ley a algunas máquinas letales autónomas. Tal acuerdo podría permitir los sistemas automatizados antimisiles.

"La pregunta es si los sistemas son capaces de discriminación", dijo Peter Asaro, uno de los fundadores de la ICRAC y profesor en la New School de Nueva York que enseña un curso sobre la guerra digital. "La buena tecnología está lejos, pero la tecnología que no funciona bien ya está ahí. La preocupación es que estos sistemas van a ser lanzados antes de tiempo, y hacen un montón de errores, y esos errores van a ser las atrocidades. "

La investigación sobre la autonomía, algunos de ellos clasificados, se aventajó en las universidades y centros de investigación en los Estados Unidos, y que el esfuerzo está comenzando a ser replicado en otros países, especialmente China.

"La autonomía letal es inevitable", dijo Ronald C. Arkin, el autor de "Comportamiento de Gobierno letal en robots autónomos," un estudio que fue financiado por la Oficina de Investigación del Ejército.

Arkin considera que es posible la construcción de aviones militares y robots éticos, capaces de usar la fuerza letal mientras se programan para respetar el derecho internacional humanitario y las normas de combate. Él dijo que se puede crear software para devolver el fuego con proporcionalidad, minimizar los daños colaterales, reconocer la rendición, y, en el caso de duda, maniobra de volver a evaluar o esperar a una evaluación humana.

En otras palabras, las reglas tal como lo entienden los seres humanos se pueden convertir en algoritmos seguidos po máquinas para todo tipo de acciones en el campo de batalla.

"¿Cómo una unidad de combate puede pensar - que estamos tratando de hacer que nuestros sistemas se comportan así", dijo Lora G. Weiss, científico jefe en el Georgia Tech Research Institute.

Otros, sin embargo, permanecen escépticos de que los seres humanos se pueden tomar fuera del circuito.

"La autonomía es en realidad el talón de Aquiles de la robótica", dijo Johann Borenstein, director del Laboratorio de Robótica Móvil de la Universidad de Michigan. "Hay una gran cantidad de trabajo realizado, y todavía no hemos llegado a un punto donde se emplea la autonomía en el campo militar. Todos los robots en el ejército son a control remoto. ¿Cómo se siente con el hecho de que la autonomía se ha trabajado en las universidades y las empresas por más de 20 años? "

Borenstein dijo que las capacidades humanas seguirán siendo cruciales en la batalla en el futuro.

"La primera de todas las habilidades es de sentido común", dijo. "Los robots no tienen sentido común y no tendrán sentido común en los próximos 50 años, o el tiempo que uno quiera".

Fuente: http://www.washingtonpost.com/natio...ated-killing/2011/09/15/gIQAVy9mgK_print.html