Nvidia Serie 3000

- Iniciador del tema bodaru

- Fecha de inicio

Estás utilizando un navegador obsoleto. Puede que este u otros sitios no se muestren correctamente.

Debes actualizarlo o utilizar un navegador alternativo.

Debes actualizarlo o utilizar un navegador alternativo.

Que resulta más conveniente una rx6600 ó una rtx 3050 ?, con un procesador Intel 10400.

jajajajjaja... Ya comenzo... lastima por los que no esperaron... solo era esperar 18 mesesitos y listo.... ese mercado de segunda es igual que las cripto .. para el suelo... XDXDXD

¿Quién carajos se espera 18 meses para comprar una GPU que necesita, por ahorrarse 1, 2 o 3 millones de pesos? Cuando se necesita, se necesita y ya. Pero si uno espera 18 meses, es porque en realidad no era tanta la necesidad.

No incluyo el precio de la 3080 de gigabyte que es más barata que es una cochinada de marca

Yo nunca he tenido problemas con Gigabyte. He tenido más con MSI y Asus que con Gigabyte. Pero sí, efectivamente no les recomiendo comprar GPUs minadas. Uno no sabe qué tanto palo le han dado, aunque hay gente que las cuida un montón. Es una lotería dar con gente así.

Pensé que la cosa sería más pareja. Muy superior esa 6600. Y ni siquiera es la XT

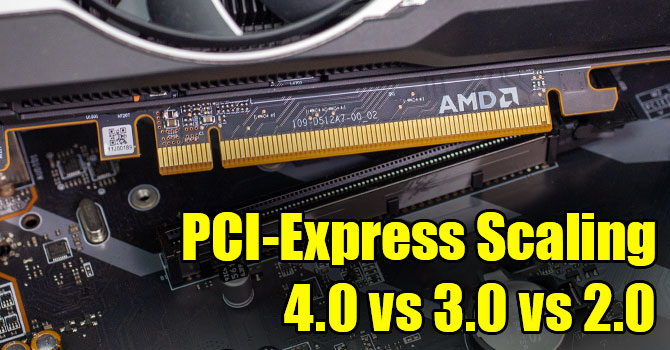

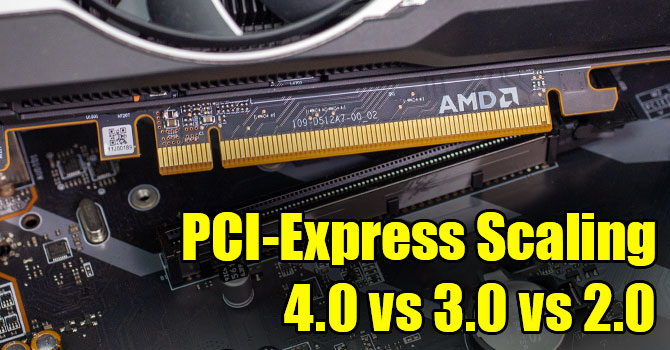

Yo me hice la misma pregunta y mirando reviews resulta que la 6600 para sacarle el jugo necesita de PCI 4.0 y el procesador 10400 no soporta eso (eso fue lo que entendí). Creo que los que soporta son chips de 11 gen en adelante. Por lo anterior en lo personal me iría por la 3050Que resulta más conveniente una rx6600 ó una rtx 3050 ?, con un procesador Intel 10400.

Yo me hice la misma pregunta y mirando reviews resulta que la 6600 para sacarle el jugo necesita de PCI 4.0 y el procesador 10400 no soporta eso (eso fue lo que entendí). Creo que los que soporta son chips de 11 gen en adelante

No es que "le saque el jugo" es que requiere si o si ese bw para funcionar decentemente . Es preferible algún otro modelo no tan bus dependiente.

No a la 6600 no le afecta PCIe 3.0, es a la 6500xtYo me hice la misma pregunta y mirando reviews resulta que la 6600 para sacarle el jugo necesita de PCI 4.0 y el procesador 10400 no soporta eso (eso fue lo que entendí). Creo que los que soporta son chips de 11 gen en adelante. Por lo anterior en lo personal me iría por la 3050

Yo me hice la misma pregunta y mirando reviews resulta que la 6600 para sacarle el jugo necesita de PCI 4.0 y el procesador 10400 no soporta eso (eso fue lo que entendí). Creo que los que soporta son chips de 11 gen en adelante. Por lo anterior en lo personal me iría por la 3050

¿Qué tanta puede ser la caída en rendimiento con eso de no poderle sacar el jugo? Porque si es un 10-15%, aún así seguiría rindiendo más que la 3050 según el video que acaban de postear. Pensé que estaban mucho más parejas.

Estuve en ese dilema toda la semana pasada, mirando reviews, comparaciones etc.. entre 6600 .. la 6600xt y 3050 y 3060 ... y al final por consumo/precio/rendimiento pedí la 6600 ... es la mas barata y está solo un poquito abajo de la 3060 consumiendo mucho menosQue resulta más conveniente una rx6600 ó una rtx 3050 ?, con un procesador Intel 10400.

Pero ojo, tiene 2 contras irse por AMD... 1. que las RTX van a envejecer mejor por el DLSS.. esa pinche tecnologia le va a alargar bastannte la vida a esas tarjetas.. por eso aunque las AMD sean mas eficientes y rindan igual o mejor que las Nvidia consumiendo menos, parece que la gente prefiere ir a futuro por el DLSS que sin duda es mucho mejor que el RSR de amd.. y mas si lo mejoran año a año como tiene la pinta..

Y la otra pega que le encontré es que las AMD usan PCIe x8 ... no x16 pero al final poniendo en balanza no lo vi tan drástico.

Tambien está el RayTracing que las RTX se llevan por delante a cualquier AMD pero no es que me importe mucho el RT .. al final como consumidor de entrada que juego mis horas casual pero no me dedico a esto, ni streameo ni edito... puse el precio y el consumo por delante.. luego viene la serie 4000 con sus consumos de 300 y 400Watts y nooo mk muy rico y todo pero q gononea xd encambio la serie 7000 de amd promete incluso 50% + de rendimiendo por Watt que la actual serie 6000.. puede que me duela esta compra en unos meses pero ya tenia mucho tiempo sin tarjeta no me aguanté xD

Y no es que no le afecte, osea la 6500XT si es un caso aislado que especificamente SI se vuelve una KK en PCIe 3.0... pero tambien a la 6600 y a todas les va a afectar correr en 3.0 en lugar de 4.0.. pero si, no es tan drástico como en ese caso de la 6500xtNo a la 6600 no le afecta PCIe 3.0, es a la 6500xt

Todo el mercado esta cayendo.... hasta aqui llego las tecnologicas.... bueno.. tuvieron sus 15 minutos de fama:

Joatrex lo resumió bien.

¿Qué tanta puede ser la caída en rendimiento con eso de no poderle sacar el jugo? Porque si es un 10-15%, aún así seguiría rindiendo más que la 3050 según el video que acaban de postear. Pensé que estaban mucho más parejas.

Ya vieron Ebay?.

Las 3090 ya los mineros las estan vendiendo a 900 dolares o 1000 dolares.

Buscan con ansias deshacerce de ellas...

Yo mi 3090 si no la voy a regalar... Quiero ver primero que tan buena es la 4080, y si me gusta, le doy la 3090 a mi esposa.... Bastante me costo conseguirme esa founder edition.

Y si la 4080 corre parecido a una 3090 me quedo con ella (la 3090)......

Ademas que si a mi nunca me gusto la mineria..... Solo para trabajo de Animacion y Jugar.

Las 3090 ya los mineros las estan vendiendo a 900 dolares o 1000 dolares.

Buscan con ansias deshacerce de ellas...

Yo mi 3090 si no la voy a regalar... Quiero ver primero que tan buena es la 4080, y si me gusta, le doy la 3090 a mi esposa.... Bastante me costo conseguirme esa founder edition.

Y si la 4080 corre parecido a una 3090 me quedo con ella (la 3090)......

Ademas que si a mi nunca me gusto la mineria..... Solo para trabajo de Animacion y Jugar.

El "equivalente" de DLSS de parte de AMD es FSR, la ventaja es que mas juegos lo soportan, igual no recomendaria ninguno de los dos en 1080pEstuve en ese dilema toda la semana pasada, mirando reviews, comparaciones etc.. entre 6600 .. la 6600xt y 3050 y 3060 ... y al final por consumo/precio/rendimiento pedí la 6600 ... es la mas barata y está solo un poquito abajo de la 3060 consumiendo mucho menos

Pero ojo, tiene 2 contras irse por AMD... 1. que las RTX van a envejecer mejor por el DLSS.. esa pinche tecnologia le va a alargar bastannte la vida a esas tarjetas.. por eso aunque las AMD sean mas eficientes y rindan igual o mejor que las Nvidia consumiendo menos, parece que la gente prefiere ir a futuro por el DLSS que sin duda es mucho mejor que el RSR de amd.. y mas si lo mejoran año a año como tiene la pinta..

Y la otra pega que le encontré es que las AMD usan PCIe x8 ... no x16 pero al final poniendo en balanza no lo vi tan drástico.

Tambien está el RayTracing que las RTX se llevan por delante a cualquier AMD pero no es que me importe mucho el RT .. al final como consumidor de entrada que juego mis horas casual pero no me dedico a esto, ni streameo ni edito... puse el precio y el consumo por delante.. luego viene la serie 4000 con sus consumos de 300 y 400Watts y nooo mk muy rico y todo pero q gononea xd encambio la serie 7000 de amd promete incluso 50% + de rendimiendo por Watt que la actual serie 6000.. puede que me duela esta compra en unos meses pero ya tenia mucho tiempo sin tarjeta no me aguanté xD

Y no es que no le afecte, osea la 6500XT si es un caso aislado que especificamente SI se vuelve una KK en PCIe 3.0... pero tambien a la 6600 y a todas les va a afectar correr en 3.0 en lugar de 4.0.. pero si, no es tan drástico como en ese caso de la 6500xt

Lo de los PCIe lanes es el problema con la AMD 6500, esta solo tiene 8x, el problema con eso es que si su mobo no soporte PCIe 4 le toca usar 8 lanes de PCIe 3:

Última edición:

Ya vieron Ebay?.

Las 3090 ya los mineros las estan vendiendo a 900 dolares o 1000 dolares.

Buscan con ansias deshacerce de ellas...

Yo mi 3090 si no la voy a regalar... Quiero ver primero que tan buena es la 4080, y si me gusta, le doy la 3090 a mi esposa.... Bastante me costo conseguirme esa founder edition.

Y si la 4080 corre parecido a una 3090 me quedo con ella (la 3090)......

Ademas que si a mi nunca me gusto la mineria..... Solo para trabajo de Animacion y Jugar.

De hecho eso se ha visto en compraventa. Hay gente que aun esta vendiendo a precio de hace unos meses. Y no le bajan mas para no perderles "tanto"

Yo la verdad no las vendería a menos que necesite la plata asi demasiado urgente, el mercado ya es otro y por esos precios sale mas barato comprar NUEVO.

exactamente es lo que yo decia (yo puse los precios mas arriba)... las gama alta se van para el piso... la gente que tiene la plata no va a comprar nada de 3070ti para arriba... el mercado se esta inundando de 3070ti, 3080, etc.etc.etc... y todos saben que estan minadas y los mineros muy brutos pensaron que recuperarian el costo y ganarian con la reventa... el mercado de segunda se va de piso pal estanco....Ya vieron Ebay?.

Las 3090 ya los mineros las estan vendiendo a 900 dolares o 1000 dolares.

Buscan con ansias deshacerce de ellas...

Yo mi 3090 si no la voy a regalar... Quiero ver primero que tan buena es la 4080, y si me gusta, le doy la 3090 a mi esposa.... Bastante me costo conseguirme esa founder edition.

Y si la 4080 corre parecido a una 3090 me quedo con ella (la 3090)......

Ademas que si a mi nunca me gusto la mineria..... Solo para trabajo de Animacion y Jugar.

Usted mismo lo decia antes: las minadas se van a dañar muy facil. Con esa idea en el mercado pues nadie va a comprar a esos precios.... vamos a ver 3090 a US$500 y van a ser muy dificiles de vender.. y ahi arrastra al resto del mercado... 1000,2000 y 3000....

Por culpa de los mineros se tiraron practicamente todo el mercado de segunda... no esperen que puedan vender sus tarjetas muy caritas que digamos...

Última edición:

Usted mismo lo decia antes: las minadas se van a dañar muy facil. Con esa idea en el mercado pues nadie va a comprar a esos precios.... vamos a ver 3090 a US$500 y van a ser muy dificiles de vender.. y ahi arrastra al resto del mercado... 1000,2000 y 3000....

Uy, donde yo encuentre 3090 a $500, me compro un par y las pongo a minar. Avíseme

Tienes razon era FSR el equivalenteEl "equivalente" de DLSS de parte de AMD es FSR, la ventaja es que mas juegos lo soportan, igual no recomendaria ninguno de los dos en 1080p

Lo de los PCIe lanes es el problema con la AMD 6500, esta solo tiene 8x, el problema con eso es que si su mobo no soporte PCIe 4 le toca usar 8 lanes de PCIe 3:

Ver el archivos adjunto 514999

Y el tema del PCIe .. creo que era Linus el que habia hablado del tema o no se donde vi el articulo de que en realidad las graficas transmiten como 15 o 20 Gbps en la mayoria de juegos (esto es informacion de hace como 5 o 6 años) ahora con las nuevas tecnologias que traen los juegos supongo que será mas. El caso es que esa cantidad de informacion te la soportaba facil hasta el x4 del 3.0.. El PciE 4.0 a x16 tiene un ancho de banda tan grande que ninguna tarjeta lo aprovecha almenos en juegos, no se si en IA o edicion se llegue a usar.

El caso de la 6500xt es que justo ese modelo segun vi en foros, reddit etc.. trae algo de fabrica que hace que empeore muchisimo en 3.0 no se el que.. sin contar con que esa tarjeta ya es muuuy gama de entrada.

Pero las demas no deberian afectarse tanto por usar 3.0 ... Por ejemplo aqui hay una 3070 corriendo en PCIe 3.0 en x4 x8 x16 y salvo en los juegos modernos (que al parecer las nuevas tecnologias si implican una carga mayor de datos) el impacto es minimo entre x8 y x16... en x4 si ya le cuesta un poquito mover la info

A eso hay que sumarle el uso de los SSD nvme que casi siempre se llevan 4x del PCI (en setups de entrada* hablo siempre de entrada) y no es que te dejen trabajando la GPU a x12 que eso no existe.. de totazo te la deja trabajando a x8 y ahi estamos todos jugando sin problemas.

Y para que comprar GPU... Comprese las ASIC que están quedando a precio de huevo.... Y aproveché a minar.antes que llegue el BTC a us$10,000Uy, donde yo encuentre 3090 a $500, me compro un par y las pongo a minar. AvísemeBueno, tal vez no. Nunca he sido muy fan de las 3090 como le consta a ShiruX por su relación Costo/Beneficio en minería.

Tienes razon era FSR el equivalente

Y el tema del PCIe .. creo que era Linus el que habia hablado del tema o no se donde vi el articulo de que en realidad las graficas transmiten como 15 o 20 Gbps en la mayoria de juegos (esto es informacion de hace como 5 o 6 años) ahora con las nuevas tecnologias que traen los juegos supongo que será mas. El caso es que esa cantidad de informacion te la soportaba facil hasta el x4 del 3.0.. El PciE 4.0 a x16 tiene un ancho de banda tan grande que ninguna tarjeta lo aprovecha almenos en juegos, no se si en IA o edicion se llegue a usar.

El caso de la 6500xt es que justo ese modelo segun vi en foros, reddit etc.. trae algo de fabrica que hace que empeore muchisimo en 3.0 no se el que.. sin contar con que esa tarjeta ya es muuuy gama de entrada.

Pero las demas no deberian afectarse tanto por usar 3.0 ... Por ejemplo aqui hay una 3070 corriendo en PCIe 3.0 en x4 x8 x16 y salvo en los juegos modernos (que al parecer las nuevas tecnologias si implican una carga mayor de datos) el impacto es minimo entre x8 y x16... en x4 si ya le cuesta un poquito mover la info

A eso hay que sumarle el uso de los SSD nvme que casi siempre se llevan 4x del PCI (en setups de entrada* hablo siempre de entrada) y no es que te dejen trabajando la GPU a x12 que eso no existe.. de totazo te la deja trabajando a x8 y ahi estamos todos jugando sin problemas.

Aqui por ejemplo RTX3070 en 3.0 y 4.0 y el resultado es tan parecido que aveces por margen de error la 3.0 saca mejores resultados que en 4.0.. por eso no le vi tanto drama a que la 6600 fuera x8 peero tampoco entiendo que ganas de limitar la tarjeta a que solo de como maximo ESE rendimiento, estrategias de mercado supongo por parte de AMD...

Si, correcto las GPU no usan full ancho de banda de PCIe aun, ni las 3090 Ti muestra mucha diferencia entre PCIe 3 y 4 a 16x.

Ademas de la combinacion de la version de PCIe y los lanes, tambien es importante lo que soporte la GPU de fabrica. Ya verifique y la 6500XT solo soporta 4x no 8x (mi error) osea peor aun.

En su video se ve por ejemplo que GTA 5 pierde como 40% de fps, mientras que overwatch casi nada, ese es el detalle, que no en todos los juegos se ve la diferencia, puede variar considerablemente, el siguiente es un analisis detallado y lo llevaron al extremo haciendo tests incluso con PCIe 2.0 que muestra lo mismo:

Full analisis con mas juegos:

AMD Radeon RX 6500 XT PCI-Express Scaling

The AMD Radeon RX 6500 XT comes with only a narrow PCI-Express x4 interface. In this article, we took a closer look at how performance is affected when running at PCI-Express 3.0; also included is a full set of data for the academically interesting setting of PCI-Express 2.0.

Otro factor que hace las diferencias mas notables es al ser tarjeta gama baja se va a notar mucho mas perder 30% de fps que en una gama alta, bajar de 60 fps a 45 se notara mucho mas que bajar de 200 a 150.

Otro video con analisis mas detallado

Full video:

Si, correcto las GPU no usan full ancho de banda de PCIe aun, ni las 3090 Ti muestra mucha diferencia entre PCIe 3 y 4 a 16x.

Ademas de la combinacion de la version de PCIe y los lanes, tambien es importante lo que soporte la GPU de fabrica. Ya verifique y la 6500XT solo soporta 4x no 8x (mi error) osea peor aun.

En su video se ve por ejemplo que GTA 5 pierde como 40% de fps, mientras que overwatch casi nada, ese es el detalle, que no en todos los juegos se ve la diferencia, puede variar considerablemente, el siguiente es un analisis detallado y lo llevaron al extremo haciendo tests incluso con PCIe 2.0 que muestra lo mismo:

Ver el archivos adjunto 515153

Full analisis con mas juegos:

AMD Radeon RX 6500 XT PCI-Express Scaling

The AMD Radeon RX 6500 XT comes with only a narrow PCI-Express x4 interface. In this article, we took a closer look at how performance is affected when running at PCI-Express 3.0; also included is a full set of data for the academically interesting setting of PCI-Express 2.0.www.techpowerup.com

Otro factor que hace las diferencias mas notables es al ser tarjeta gama baja se va a notar mucho mas perder 30% de fps que en una gama alta, bajar de 60 fps a 45 se notara mucho mas que bajar de 200 a 150.

Otro video con analisis mas detallado

Ver el archivos adjunto 515147

Full video:

Ah entonces era eso, que la 6500xt es x4 ... es que si, ya x4 para el dia de hoy ya no dá ... y en 3.0 peor... pero ve la RX6600 siendo x8 ahi arribita al lado de la 3060 .. seria bueno ver una grafica asi pero todas en 3.0 para ver que tanto bajan las x8 en promedio

Última edición:

Los últimos temas

-

Vendo portátil ASUS Strix Scar i9 3070ti 1tb 16RAM

- Iniciado por jorgejimro

- Respuestas: 0

-

-

-

-