He estado leyendo sus comentarios y me he reservado a responder hasta concluir en base a sus posts la decisión más acertada.

Elluisro, en un inicio estuve de acuerdo contigo, aunque no te lo haya dicho públicamente, pero después de ver la respuesta de KiKe, dA_vO e ISAexpress, cambió mi perspectiva completamente.

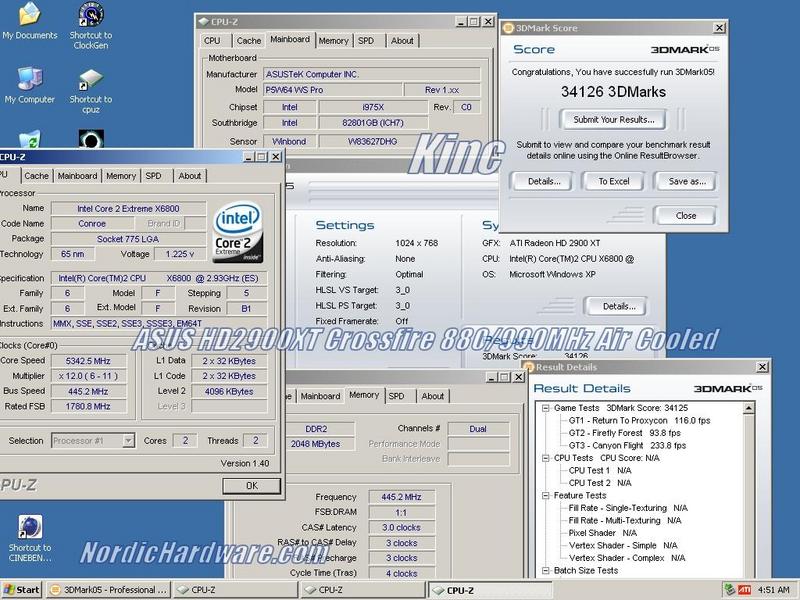

Mira elluisro, lo que pasa con Call of Juarez de DX10, que comentas que sale rindiendo más que una 8800 GTX a veces, es porque ATi no lo quiso decir pero reveló que ese demo tecnológico estaba optimizado para ATi, lo dije antes, no me acuerdo dónde, creo que en el tema de Tarjetas de DX10.

A ver, y la ATi esa ¿ofrece quantum effects?, son los primeros procesamientos físicos, ya nada de Ageia, eso ya lo tiene implementado Nvidia.

De resto ya no hay nada que decir, ISAexpress lo dijo más claro, ya no le demos tanta vuelta a esto, sale más caro comprarse una HD2900XT por donde lo vean, quizás la solución contra las 8800 GTX y Ultra sea la HD2950XTX, pero ya están próximas a salir las G90, salen por finales de año, imagínense una 9800 GTS o 9800 GTX con Shader Model 5.0 uuuuuf.

Un Saludo

Elluisro, en un inicio estuve de acuerdo contigo, aunque no te lo haya dicho públicamente, pero después de ver la respuesta de KiKe, dA_vO e ISAexpress, cambió mi perspectiva completamente.

Mira elluisro, lo que pasa con Call of Juarez de DX10, que comentas que sale rindiendo más que una 8800 GTX a veces, es porque ATi no lo quiso decir pero reveló que ese demo tecnológico estaba optimizado para ATi, lo dije antes, no me acuerdo dónde, creo que en el tema de Tarjetas de DX10.

A ver, y la ATi esa ¿ofrece quantum effects?, son los primeros procesamientos físicos, ya nada de Ageia, eso ya lo tiene implementado Nvidia.

De resto ya no hay nada que decir, ISAexpress lo dijo más claro, ya no le demos tanta vuelta a esto, sale más caro comprarse una HD2900XT por donde lo vean, quizás la solución contra las 8800 GTX y Ultra sea la HD2950XTX, pero ya están próximas a salir las G90, salen por finales de año, imagínense una 9800 GTS o 9800 GTX con Shader Model 5.0 uuuuuf.

Un Saludo