Para los que se preguntan cuál es mejor entre AMD y Nvidia aquí les dejo una grafica.

Nvidia Serie 3000

- Iniciador del tema bodaru

- Fecha de inicio

Estás utilizando un navegador obsoleto. Puede que este u otros sitios no se muestren correctamente.

Debes actualizarlo o utilizar un navegador alternativo.

Debes actualizarlo o utilizar un navegador alternativo.

Para los que se preguntan cuál es mejor entre AMD y Nvidia aquí les dejo una grafica.

Ver el archivos adjunto 436763

Para los que se preguntan cuál es mejor entre AMD y Nvidia aquí les dejo una grafica.

Acá una mas completa:

fuera de bromas a ese precio de la 3090 yo no la compraria ni si me la ofrecieran en 1000 dolares, para que en 10 meses saquen una 4080 a 700 bien jugado nvidia y pobres los que la compren.

PTSD de la 2080 Ti, ya con la 3070 en el mercado se fue en picada el preciofuera de bromas a ese precio de la 3090 yo no la compraria ni si me la ofrecieran en 1000 dolares, para que en 10 meses saquen una 4080 a 700 bien jugado nvidia y pobres los que la compren.

Con la competencia que ahora le esta dando Amd van a tener que sacrificar margen de beneficios... y bueno seguramente sacaran una super o ti próximamente.Con la 3090 uno está pagando por los 24GB de VRAM básicamente.

Por más 4080 que saquen dudo que en 10 meses el costo del GDDR6X baje lo suficiente como para bajen el precio sin sacrificar ese márgen sabroso del 60% que dicen que le gusta a NVIDIA.

Última edición:

Rumor de lanzamiento de la 3060ti el 17 de noviembre

NVIDIA GeForce RTX 3060 Ti to launch on November 17th?

NVIDIA GeForce RTX 3060 Ti to launch on November 17th?

Jum ya están buscando que hacer con los GA104 que no llegan al spec de la 3070 y ni siquiera han lanzado ningún producto con el GA106.

Lo chistoso es que bien poquitos que si deben ser.

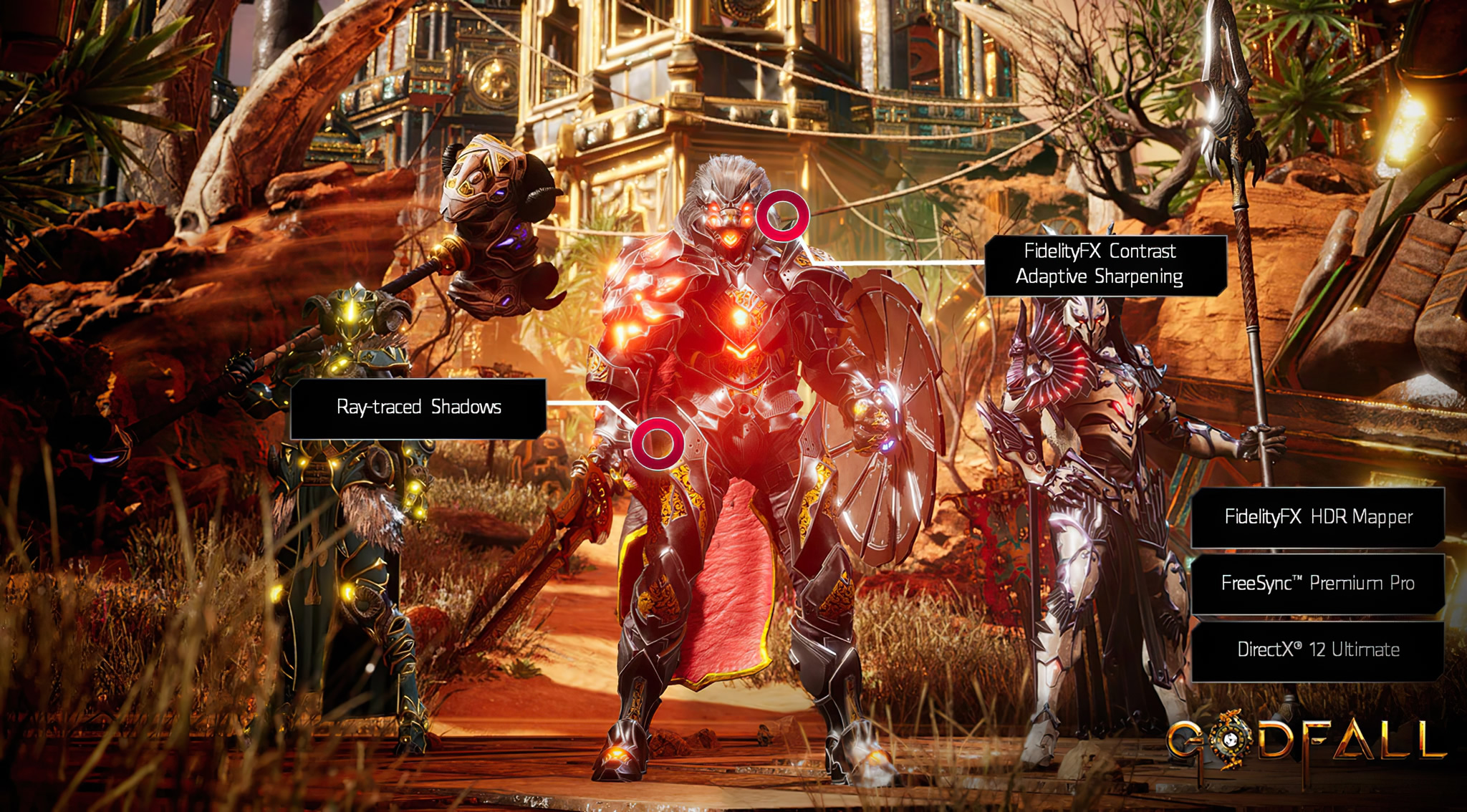

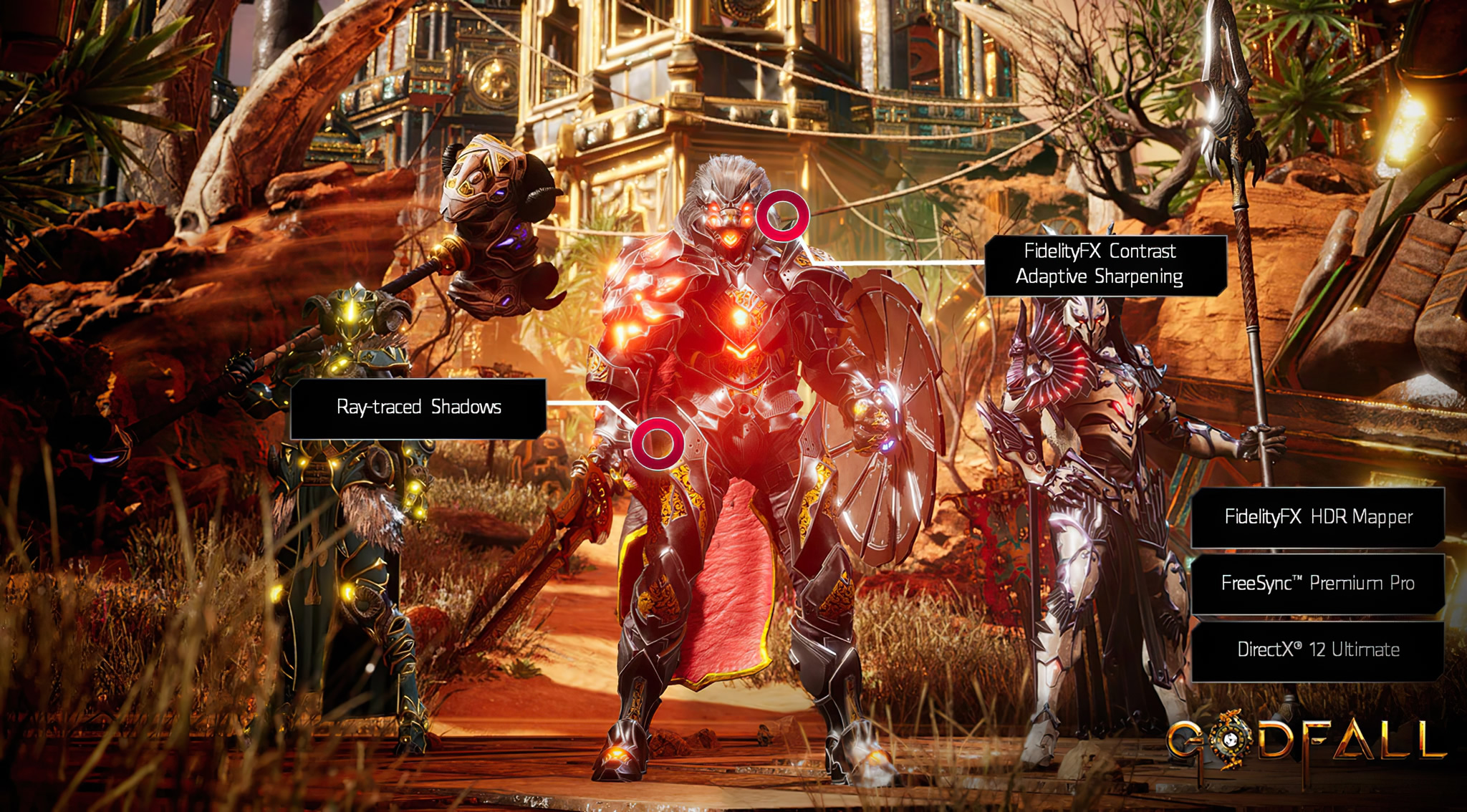

Algo a lo que tener en cuenta si eres fan de este juego o a futuro de otros juegos.

elchapuzasinformatico.com

elchapuzasinformatico.com

La GeForce RTX 3080 no puede mover Godfall @ 4K con RayTracing por falta de memoria VRAM

Ayer conocíamos los elevados requisitos de hardware de Godfall, y la cosa empeora para Nvidia con los 4K con RayTracing.

Eso parece una publicidad de AMD

Realmente para mí no tiene sentido que un juego necesite 12GB de VRAM así sea en 4K. Ni Red Dead Redemption 2 usa en en 4K, y hay muchos juegos que hasta en 8K no llegan a 8GB.

Igual es muy poquita a gente que juega en 4K en PC.

Realmente para mí no tiene sentido que un juego necesite 12GB de VRAM así sea en 4K. Ni Red Dead Redemption 2 usa en en 4K, y hay muchos juegos que hasta en 8K no llegan a 8GB.

Igual es muy poquita a gente que juega en 4K en PC.

Tiempo al tiempo viejo, la adición de raytracing y el típico aumento en fidelidad gráfica van a aumentar el uso de VRAM, no lo dudeEso parece una publicidad de AMD

Realmente para mí no tiene sentido que un juego necesite 12GB de VRAM así sea en 4K. Ni Red Dead Redemption 2 usa en en 4K, y hay muchos juegos que hasta en 8K no llegan a 8GB.

Igual es muy poquita a gente que juega en 4K en PC.

Eso y las API's de acceso directo a la vram (DirectStorage) para no pasar por la CPU, se me hace que por ahi es por donde vamos a ver un gran incremento del consumo del uso de la vram.Tiempo al tiempo viejo, la adición de raytracing y el típico aumento en fidelidad gráfica van a aumentar el uso de VRAM, no lo dude

La gtx 3060 será "lanzada" en diciembre 2.

Algo me dice que será un teaser teaser teaser teaser trailer.

Disponible julio 2025 (?)

Algo me dice que será un teaser teaser teaser teaser trailer.

Disponible julio 2025 (?)